Google adalah sahabat Tuan Web atau webmaster.

Pada awal kompetisi ketat di antara mesin pencari, Google sudah sangat memudahkan pengelola web mengirimkan URL untuk didatangi rayap (crawler) Google. Sebagian mesin pencari lain mengandalkan layanan berbayar hanya untuk setor URL, sehingga proses pengenalan situs Web ke mesin pencari terkadang dijadikan satu paket dengan layanan tempat hosting.

Perolehan URL situs baru kian membaik dan menurut saya untuk saat ini pengelola situs Web tidak perlu mengirim URL situs baru mereka ke mesin pencari. Tautan dari halaman lain ke tempat baru tersebut boleh dikata tak akan lama mengundang bot Google untuk datang menjenguk. Alat bantu blog juga melakukan sejumlah notifikasi (lewat ping entri baru) ke layanan yang berkait dengan blog dan ini sudah cukup untuk mengajak aneka bot lain.

Dengan kata lain: urusan setor URL sudah beres dan sangat mudah!

Google Webmaster Tools

Akhirnya kita dapat terbantu untuk keperluan selanjutnya, berupa seperangkat layanan pengelolaan web dari Google. Saya pasang fasilitas Sitemap (peta situs) yang tersedia di Google Webmaster Tools. Sitemap menggunakan beberapa teknik untuk membantu Google menentukan halaman web yang dianggap “penting”. Intinya: terdapat mekanisme yang menghubungkan antara persepsi pengelola web tentang kondisi situsnya dengan kepentingan Google menyajikan hasil pencarian yang lebih baik. Protokol Sitemap mengakomodasi informasi tambahan tentang bagian-bagian situs Web, seperti dijelaskan di halaman Using the Sitemap Protocol.

Saya pasang Sitemap Generator dari Google untuk menghasilkan berkas Sitemap dengan pertimbangan produk tersebut dari Google dan Python yang disyaratkan tersedia di tempat hosting. Agar penyediaan Sitemap dimutakhirkan secara reguler, cron di Linux sangat membantu.

Blog ini disimpan dalam bentuk berkas statik (bagian dinamik yang menggunakan PHP sangat minor), untuk itu saya pilih pendekatan Directory Paths digabung dengan Access Logs. Pertimbangan saya: selain senarai URL, log pengunjung dapat dijadikan masukan perihal halaman yang dianggap “populer”. Penyusunan example_config.xml, yaitu berkas konfigurasi untuk Sitemap, relatif mudah dilakukan.

Akan halnya beberapa wiki yang dijalankan di atas MoinMoin, saya memilih pendekatan Access Logs karena halaman dinamis yang dihasilkan berbeda dengan struktur di direktori penyimpanan fisiknya. Barangkali ada kemungkinan lain? Saya belum mempertimbangkan terlalu jauh untuk situs Web dinamik.

Agar tidak terlalu membebani server Web, saya bedakan rentang pemutakhiran Sitemap. Toh, pengunjung wiki lebih sedikit dibanding blog ini.

Setelah semua siap, tinggal melengkapi prosedur administrasi di Google. Verifikasi kepemilikan situs dan pemasangan tautan berkas Sitemap yang telah dipasang.

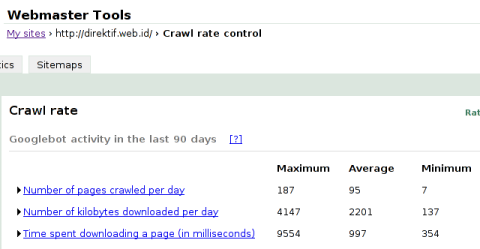

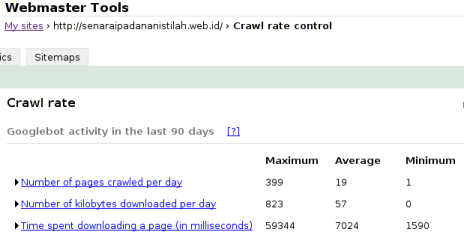

Semua beres dan setelah beberapa hari dipasang, bagian yang menarik adalah kecepatan situs Web dalam merespon rayap Google. Di bawah ini ditampilkan hasil untuk #direktif, Weling, dan Senarai Padanan Istilah.

Kecepatan akses untuk #direktif.

Versi lebih besar (100 kB).

Kecepatan akses untuk Weling.

Versi lebih besar (96 kB).

Kecepatan akses untuk Senarai Padanan Istilah.

Versi lebih besar (87 kB).

Dengan rata-rata hampir satu detik untuk halaman #direktif saya anggap wajar untuk pemakaian PHP. Agar jelas, mesin Movable Type menggunakan Perl sedangkan untuk halaman yang dihasilkan dipilih PHP untuk keperluan penyisipan (fungsi include()) berkas lain. Akses basisdata ditangani oleh templat komentar, berbasis Perl, dan tidak terukur oleh rayap Google.

Sayang saya belum membandingkan hasil di atas dengan WordPress yang menggunakan pendekatan halaman blog ditangani langsung oleh mesin WordPress dan intensif akan akses basisdata. Di sisi lain, pemakaian plugin WP-Cache seharusnya mengurangi ongkos akses ke basisdata, namun saya mengalami kesulitan karena halaman lama bertengger di proxy Web bahkan setelah WP-Cache distop.

Python memang “agak merisaukan” dalam hal kecepatan. Ada kecenderungan bahasa pemrograman yang rapi-jali dan disiplin kalah gesit dibanding kompetitornya yang main tancap. Ingat-ingat zaman Pascal versus C, Java versus PHP di lingkungan Web, dan Python tentu berkompetisi erat dengan Perl. Barangkali saya terpukau Perl akan kecepatannya dan terkesima Python akan kebersihannya. Andry S. Huzain pernah “mengingatkan” saya perihal Python waktu saya sentil Java — alon-alon waton Java.

Penafian: tulisan ini bukan tes unjuk kerja atau studi banding bahasa pemrograman.

Rata-rata lima detik untuk halaman MoinMoin di Weling dan kasus terburuk hingga sembilan belas detik — lebih dari delapan detik — sangat berisiko halaman tersebut ditinggal pengunjung. Tidak ada akses basisdata, justru saya curiga mesin MoinMoin menghabiskan usianya untuk berdendang ke sana ke mari di antara puluhan berkas dan subdirektori. Terutama untuk halaman yang belum tersedia salinannya di tembolok (cache).

Ada yang bersedia berbagi laporan rayap Google untuk alat bantu Wiki berbasis PHP? MediaWiki dan PmWiki adalah contoh yang menarik dilihat dari cara penyimpanan halaman Wiki dalam bentuk basisdata atau berkas.

Laporan lain yang diberikan Google di Webmaster Tools membantu untuk analisis kegagalan kunjungan, URL bermasalah, kunjungan bot terakhir, pemakaian robots.txt, hingga kata kunci yang mengantarkan pengunjung ke situs kita. Seperti judul alat bantu tersebut, informasi tersebut memang lebih cocok untuk pengelola Web dari sisi teknis.

Google Analytics

Saya memakai Anaytics lebih dulu dibanding Webmaster dan sempat diselingi kekecewaan. Kejutan pertama adalah tampilan di Analytics yang disajikan menggunakan Flash. Terasa janggal untuk gaya Google yang lebih menyukai teks dan elemen HTML “apa adanya”. Flash adalah pertanda buruk dan terus terang sering saya awali dengan praduga bersalah. Flash itu pula yang saya jauhi dari FlickrBadge — lebih baik saya tunjuk-tanpa-tender JavaScript. Gara-gara spekulasi Google dengan mensyaratkan Macromedia Flash Player 8, grafik mereka yang seharusnya indah menjadi ompong sonder legenda di Ubuntu. Siapa yang patut dipersalahkan jika pemutar Flash untuk Linux tertinggal satu versi terhadap Microsoft Windows?

Lebih fatal lagi: dengan koneksi keroyokan ala kantoran, petak-petak Flash tersebut melompong di siang bolong…

Walaupun saya tetap berkompromi: skrip Analytics saya pasang lagi, toh ada kemungkinan saya memerlukan laporan yang sudah dikelompokkan untuk eksekutif, pemasar, dan tuan Web. Budi Putra pernah bercerita cara dia mempresentasikan pengunjung blognya a.l. cukup dengan menyajikan materi di Google Analytics.

Demikianlah Google. Seperti yang sudah-sudah, saya acung jempol untuk mereka karena sering menyuguhkan kemudahan untuk pekerja teknis.

Baru sebatas menggunakan analytics, jadi penasaran mencoba webmaster toolsnya nih (yayaya saya latebloomer hehehe.)

Terima kasih tipsnya. Sangat bermanfaat.

Selama ini, karena keterbatasan waktu, saya tidak sempat mengeksplor Google Webmaster Tool (terutama Crawl Rate). Setelah membaca posting ini, saya meluangkan waktu untuk mengecek Crawl Rate dari dua website yang saya miliki.

Setelah membandingkan data dari kedua website tersebut (yang menggunakan engine yang sama namun beda hosting), saya menemukan performance yang masih belum sesuai harapan pada salah satu website. Website yang performansinya rendah itu justru yang isinya menurut saya lebih “ringan”. Mungkin ini saatnya bagi saya untuk pindah hosting :-)

Terima kasih kembali. :)

Syukurlah jika bermanfaat bagi para pengelola Web untuk mencoba Webmaster Tools.

Artikelnya menarik, kalo bisa lebih detil lagi dan bahasanya yg lebih mudah dipahami, maklum masih awam. Thanks.

Mas Amal

Aku ini orang awam di bidang IT, tetapi nekat mau belajar ing-‘sun’ Java, jadi aku minta ijin copy semua naskah Java mu , maaf sudah copy duluan :), just for learn no commercial.

Dan saya akan klak klik di search (pencarian Google) itu koq :}, semoga jadi barter bagus. Kalo ndak berhasil email saya, nanti saya klak klik lagi :)

Atau ada teman-teman lain yang butuh klak klik, email saya saja, nanti kita tukeran dengan info :)

Salam Roust